Daftar Isi:

- Pengarang Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:48.

- Terakhir diubah 2025-01-22 17:27.

Mengumpulkan (Aksi) - Mengembalikan semua elemen dataset sebagai larik pada program driver. Ini biasanya berguna setelah filter atau operasi lain yang mengembalikan subset data yang cukup kecil.

Jadi, apa itu PySpark?

PySpark Pemrograman. PySpark adalah kolaborasi Apache Spark dan Python. Apache Spark adalah kerangka kerja komputasi klaster open-source, dibangun berdasarkan kecepatan, kemudahan penggunaan, dan analitik streaming sedangkan Python adalah bahasa pemrograman tingkat tinggi untuk tujuan umum.

Juga, apa itu peta di PySpark? Percikan Peta Transformasi. A peta adalah operasi transformasi di Apache Spark. Ini berlaku untuk setiap elemen RDD dan mengembalikan hasilnya sebagai RDD baru. Peta mengubah RDD dengan panjang N menjadi RDD lain dengan panjang N. RDD input dan output biasanya memiliki jumlah record yang sama.

Dengan cara ini, apa itu SparkContext di PySpark?

PySpark - SparkContext . Iklan. SparkContext adalah titik masuk ke sembarang percikan Kegunaan. Ketika kita menjalankan apapun Percikan aplikasi, program driver dimulai, yang memiliki fungsi utama dan Anda SparkContext akan dimulai di sini. Program driver kemudian menjalankan operasi di dalam eksekutor pada node pekerja.

Bagaimana cara memeriksa versi PySpark?

2 Jawaban

- Buka Terminal Spark shell dan masukkan perintah.

- sc.version Atau spark-submit --version.

- Cara termudah adalah dengan meluncurkan "spark-shell" di baris perintah. Ini akan menampilkan.

- versi aktif Spark saat ini.

Direkomendasikan:

Bagaimana media sosial dapat digunakan untuk mengumpulkan data?

Data sosial adalah informasi yang dikumpulkan dari platform media sosial. Ini menunjukkan bagaimana pengguna melihat, berbagi, dan terlibat dengan konten Anda. Di Facebook, data media sosial mencakup jumlah suka, peningkatan pengikut, atau jumlah share. Di Instagram, penggunaan hashtag dan tingkat keterlibatan termasuk dalam data mentah

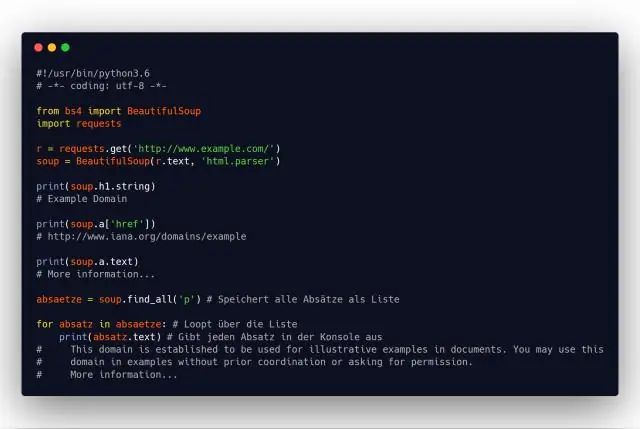

Bagaimana Python mengumpulkan data dari situs web?

Untuk mengekstrak data menggunakan scraping web dengan python, Anda harus mengikuti langkah-langkah dasar berikut: Temukan URL yang ingin Anda gores. Memeriksa Halaman. Temukan data yang ingin Anda ekstrak. Tulis kodenya. Jalankan kode dan ekstrak datanya. Simpan data dalam format yang diperlukan

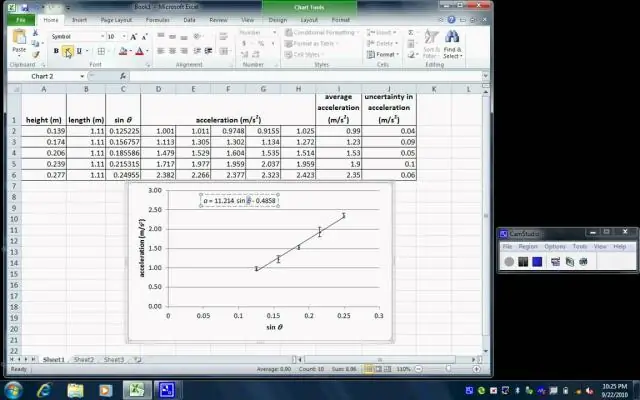

Bagaimana Anda mengumpulkan data di Excel?

Di tarik-turun kolom tautan Tabel: Klik opsi Agregat. Arahkan kursor ke item fungsi agregat, seperti Agregat UnitPrice. Dari tarik-turun fungsi agregat, pilih satu atau beberapa fungsi agregat. Misalnya, Jumlah dan Rata-rata

Mengapa kualitas data penting untuk mengumpulkan data statistik?

Data berkualitas tinggi akan memastikan efisiensi yang lebih dalam mendorong kesuksesan perusahaan karena ketergantungan pada keputusan berbasis fakta, bukan kebiasaan atau intuisi manusia. Kelengkapan: Memastikan tidak ada kesenjangan dalam data dari apa yang seharusnya dikumpulkan dan apa yang sebenarnya dikumpulkan

Bagaimana kami mengumpulkan informasi?

Cara Mengumpulkan Informasi Penghitungan/Hitungan. Rute Aman ke Formulir Penghitungan Perjalanan Siswa Sekolah. Survei. Survei atau kuesioner biasanya digunakan dalam evaluasi. Pengamatan dan Audit. Pengamatan Sekolah: Kedatangan atau Keberangkatan Siswa. Wawancara. Sumber Data yang Ada. Standar Evaluasi. Bekerja dengan Sekolah