- Pengarang Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:48.

- Terakhir diubah 2025-01-22 17:27.

penyerapan data adalah proses mendapatkan dan mengimpor data untuk segera digunakan atau disimpan dalam database. Menelan sesuatu berarti "mengambil sesuatu atau menyerap sesuatu." Data dapat dialirkan secara real time atau tertelan dalam batch.

Juga tahu, apa itu pipa penyerapan data?

Pipa Penyerapan Data . A pipa penyerapan data bergerak streaming data dan berkelompok data dari database yang sudah ada sebelumnya dan data gudang ke data Danau. Untuk berbasis HDFS data danau, alat seperti Kafka, Hive, atau Spark digunakan untuk penyerapan data . Kafka adalah yang populer penyerapan data alat yang mendukung streaming data.

Selanjutnya, bagaimana Hadoop menyerap data? hadoop menggunakan sistem file terdistribusi yang dioptimalkan untuk membaca dan menulis file besar. Saat menulis ke HDFS , data "diiris" dan direplikasi di seluruh server dalam a hadoop gugus. Proses slicing menciptakan banyak sub-unit kecil (blok) dari file yang lebih besar dan secara transparan menuliskannya ke node cluster.

Kedua, apa itu alat penyerapan data?

Alat penyerapan data menyediakan kerangka kerja yang memungkinkan perusahaan untuk mengumpulkan, mengimpor, memuat, mentransfer, mengintegrasikan, dan memproses data dari berbagai data sumber. Mereka memfasilitasi data proses ekstraksi dengan mendukung berbagai data protokol transportasi.

Apa pemahaman Anda tentang penyerapan dan integrasi data?

penyerapan data adalah NS proses dari menelan data dari satu sistem ke sistem lainnya. Integrasi data memungkinkan berbeda data jenis (seperti data set, dokumen dan tabel) untuk digabungkan dan digunakan oleh aplikasi untuk proses pribadi atau bisnis.

Direkomendasikan:

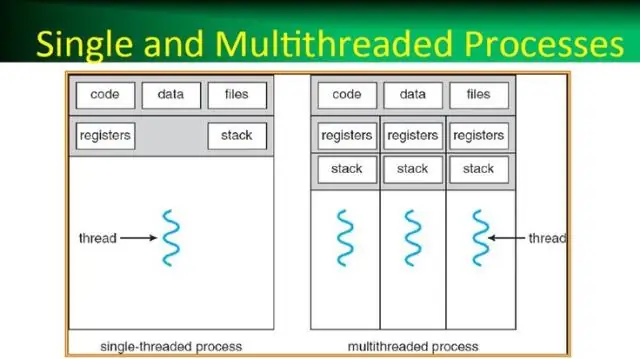

Apa itu proses dalam sistem operasi Apa itu thread dalam sistem operasi?

Sebuah proses, dalam istilah yang paling sederhana, adalah sebuah program pelaksana. Satu atau lebih utas berjalan dalam konteks proses. Thread adalah unit dasar dimana sistem operasi mengalokasikan waktu prosesor. Threadpool terutama digunakan untuk mengurangi jumlah utas aplikasi dan menyediakan pengelolaan utas pekerja

Apa yang dimaksud dengan penyerapan di Premiere?

Serap Alur Kerja. Anda dapat menggunakan panel Premiere Pro Media Browser untuk menyerap media secara otomatis di latar belakang saat Anda mulai mengedit. Kotak centang penyerapan serupa dalam dialog Pengaturan Proyek tetap sinkron dengan pengaturan panel Browser Media

Apa itu sistem data besar?

Sebuah sistem big data terdiri dari fitur wajib Data, Penyimpanan Data, Manajemen Informasi, Analisis Data, Pengolahan Data, Antarmuka dan Visualisasi, dan fitur opsional, System Orchestrator

Apa itu Impala dalam data besar?

Impala adalah mesin kueri pemrosesan paralel besar-besaran open source di atas sistem berkerumun seperti Apache Hadoop. Itu dibuat berdasarkan kertas Dremel Google. Ini adalah SQL interaktif seperti mesin kueri yang berjalan di atas Hadoop Distributed File System (HDFS). Impala menggunakan HDFS sebagai penyimpanan dasarnya

Apa itu solusi NoSQL data besar?

Tujuan penggunaan database NoSQL adalah untuk penyimpanan data terdistribusi dengan kebutuhan penyimpanan data yang sangat besar. NoSQL digunakan untuk data besar dan aplikasi web waktu nyata. Sebaliknya, sistem basis data NoSQL mencakup berbagai teknologi basis data yang dapat menyimpan data terstruktur, semi terstruktur, tidak terstruktur, dan polimorfik