Daftar Isi:

- Pengarang Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:48.

- Terakhir diubah 2025-01-22 17:28.

File Konfigurasi yang perlu diperbarui untuk menyiapkan mode Hadoop yang terdistribusi sepenuhnya adalah:

- Hadoop-env.sh.

- Situs inti. xml.

- Hdfs-situs. xml.

- Situs yang dipetakan. xml.

- Master.

- Budak.

Selain itu, apa saja file konfigurasi penting di Hadoop?

Konfigurasi Hadoop didorong oleh dua jenis file konfigurasi penting:

- Konfigurasi default read-only - src/core/core-default. xml, src/hdfs/hdfs-default. xml dan src/mapred/mapred-default. xml.

- Konfigurasi khusus situs - conf/core-site. xml, conf/hdfs-site. xml dan conf/mapred-site. xml.

Demikian pula, manakah dari berikut ini yang berisi konfigurasi untuk daemon HDFS? xml berisi konfigurasi pengaturan dari Daemon HDFS (yaitu NameNode, DataNode, Sekunder NameNode). Ini juga mencakup faktor replikasi dan ukuran blok dari HDFS.

apa file konfigurasi di Hadoop?

File Konfigurasi adalah file yang terletak di tar yang diekstraksi. gz mengajukan di dll/ hadoop / direktori. Semua File Konfigurasi di Hadoop tercantum di bawah ini, 1) HADOOP -ENV.sh->>Ini menentukan variabel lingkungan yang mempengaruhi JDK yang digunakan oleh hadoop Daemon (bin/ hadoop ).

File mana yang menangani masalah file kecil di Hadoop?

1) HAR ( hadoop Arsip) File telah diperkenalkan ke menangani masalah file kecil . HAR telah memperkenalkan lapisan di atas HDFS , yang menyediakan antarmuka untuk mengajukan mengakses. Menggunakan hadoop perintah arsip, HAR file dibuat, yang berjalan a PetaKurangi tugas mengemas file sedang diarsipkan ke lebih kecil jumlah file HDFS.

Direkomendasikan:

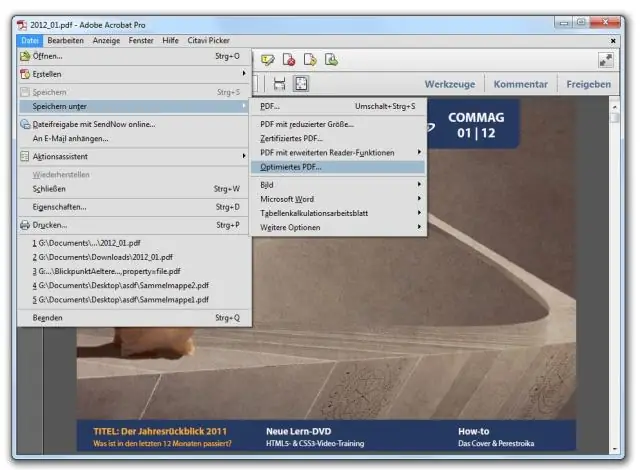

Bagaimana saya bisa mencetak file PDF yang diedit?

Mencetak ke PDF (Windows) Buka file dalam aplikasi Windows. Pilih File > Cetak. Pilih Adobe PDF sebagai printer di kotak dialog Print. Untuk menyesuaikan pengaturan printer Adobe PDF, klik tombol Properties (atau Preferences). Klik Cetak. Ketik nama untuk file Anda, dan klik Simpan

Apa parameter konfigurasi utama yang perlu ditentukan pengguna untuk menjalankan pekerjaan MapReduce?

Parameter konfigurasi utama yang perlu ditentukan pengguna dalam kerangka kerja "MapReduce" adalah: Lokasi input Job dalam sistem file terdistribusi. Lokasi keluaran pekerjaan dalam sistem file terdistribusi. Format masukan data. Format keluaran data. Kelas yang berisi fungsi peta. Kelas yang berisi fungsi pengurangan

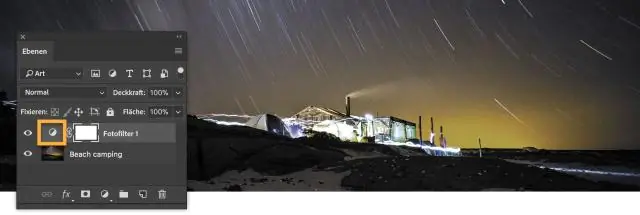

Bagaimana cara menyimpan file Photoshop untuk diedit nanti?

Pilih File > Simpan atau tekan Ctrl+S/Command-S. Atau, pilih File > Save As(Ctrl+Shift+S/Command-Shift-S) untuk menyimpan salinan baru file. Pada dialog Simpan yang muncul, pilih lokasi pada hard disk Anda (jika Anda ingin memindahkannya ke lokasi baru) A. A Simpan file agar Anda dapat mengeditnya nanti

Apa yang dimaksud dengan catatan pembicara, tulis tujuannya dan apa hal-hal penting yang perlu diingat tentang catatan pembicara?

Catatan pembicara adalah teks terpandu yang digunakan penyaji saat menyajikan presentasi. Mereka membantu presenter untuk mengingat poin penting saat memberikan presentasi. Mereka muncul di slide dan hanya dapat dilihat oleh penyaji dan bukan penonton

Perintah apa yang Anda gunakan untuk menyiapkan repositori Git di dalam folder Anda?

Mulai repositori git baru Buat direktori untuk menampung proyek. Masuk ke direktori baru. Ketik git init. Tulis beberapa kode. Ketik git add untuk menambahkan file (lihat halaman penggunaan tipikal). Ketik git commit